Hol Dir Deine Daten zurück: Warum europäische Cloud-Dienste die Zukunft sind

In der Welt des Cloud Computing ist die Abhängigkeit von US-amerikanischen Cloud-Diensten zu einem wichtigen Diskussionsthema geworden. Ich beobachte bei

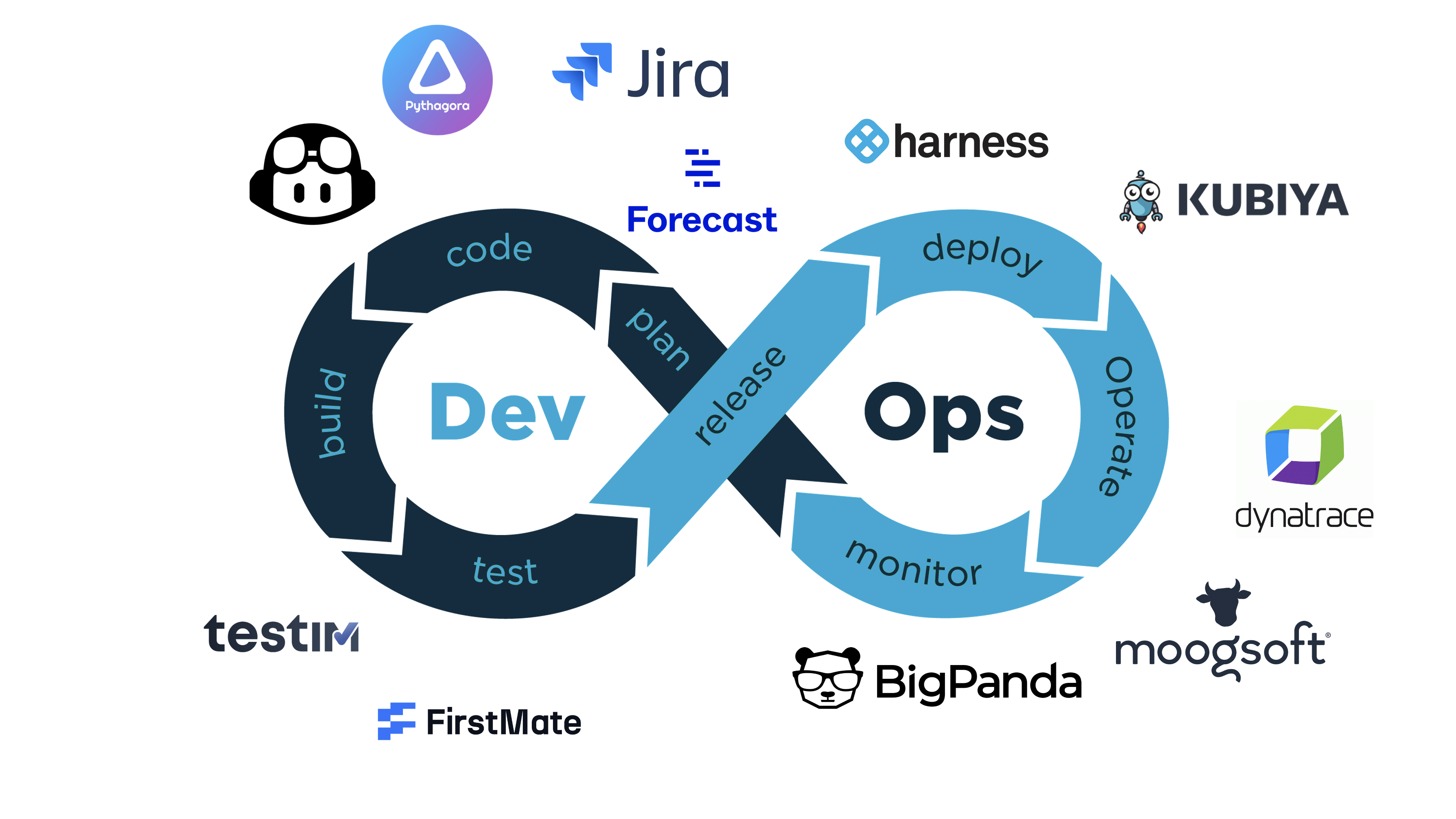

DevOps ist ein entscheidender Erfolgsfaktor in der Softwareentwicklung, und wir sind definitiv alle auf die eine oder andere Weise auf KI gestoßen. Eine Schnittstelle zwischen KI und DevOps kann die Arbeitsweise von Softwareentwicklungs- und Betriebsteams bereichern. Begleiten Sie uns bei der Erkundung des transformativen Potenzials von KI für DevOps-Ingenieure. In diesem ersten Teil unserer Blog-Reihe werden wir die Herausforderungen untersuchen, mit denen DevOps heute konfrontiert ist, wie KI bei ihrer Bewältigung helfen kann, und uns mit den Grundlagen von KI für DevOps-Engineers befassen.

Zunächst einmal: Welches Problem versuchen wir mit KI zu lösen?

Wir kennen DevOps als eine Reihe von Praktiken, die Softwareentwicklung (Dev) und IT-Betrieb (Ops) kombinieren. Das Ziel von DevOps ist es, den Lebenszyklus der Systementwicklung zu verkürzen und eine kontinuierliche Bereitstellung mit hoher Softwarequalität zu gewährleisten. DevOps ist ein entscheidender Erfolgsfaktor für die moderne Softwareentwicklung. Wenn man jedoch bedenkt, dass nicht alle das gleiche Tempo und den gleichen Grad an DevOps-Reife haben, gibt es noch viele Herausforderungen zu bewältigen:

Manuelle, fehleranfällige Prozesse: Viele DevOps-Arbeitsabläufe sind immer noch auf manuelle Eingriffe angewiesen, die zeitaufwendig und anfällig für menschliche Fehler sind. Dies verlangsamt die Abläufe und führt zu einer ineffizienten Nutzung der Infrastruktur.

Verzögerte Problemerkennung und -reaktion: Ohne Echtzeit-Datenverarbeitung haben Teams Schwierigkeiten, Probleme schnell zu erkennen und darauf zu reagieren. Dies führt zu längeren Ausfallzeiten und einem ineffizienten Vorfallmanagement.

Qualifikationsunterschiede zwischen Teams Entwicklungs- und Betriebsteams verfügen oft über unterschiedliche technische Fachkenntnisse, was die Zusammenarbeit erschwert und die Gesamtproduktivität verringert.

Skalierbarkeitsprobleme Die Skalierung von Abläufen in dynamischen Umgebungen ist ein ständiger Kampf, insbesondere ohne Automatisierung und KI-gesteuerte Prozesse.

Sicherheitslücken Das Fehlen von Echtzeit-Bedrohungserkennung und automatisierten Abwehrmaßnahmen erhöht das Risiko von Cyberangriffen und Datenlecks.

Unfähigkeit, sich an schnelle Veränderungen anzupassen In der sich schnell entwickelnden digitalen Landschaft von heute laufen Unternehmen, die keine fortschrittlichen KI-gesteuerten Lösungen einführen, Gefahr, hinter der Konkurrenz zurückzufallen.

KI bietet Lösungen für diese Herausforderungen, indem sie die menschlichen Fähigkeiten erweitert und sich wiederholende Aufgaben automatisiert. So kann KI DevOps verändern:

Letztendlich ist KI dazu da, eine ausgereifte DevOps-Praxis zu erreichen und unsere Arbeitsabläufe zu vereinfachen. KI gibt es in vielen Formen und Varianten, unabhängig davon, ob wir Tools verwenden oder unsere eigenen KI-Anwendungen und -Arbeitsabläufe erstellen. Es gibt zahlreiche KI-Tools, die zur Verbesserung von DevOps-Praktiken eingesetzt werden können.

Glücklicherweise gibt es für jede Phase des DevOps-Lebenszyklus ein Tool. Hier sind einige beliebte KI-Tools, die uns dabei helfen können, Ihre DevOps-Arbeitsabläufe zu optimieren:

Atlassian Intelligence ist ein leistungsstarkes Tool für das Projektmanagement und die Planung. Es nutzt die Verarbeitung natürlicher Sprache, um das Aufgabenmanagement zu vereinfachen und die Zusammenarbeit zu verbessern.

Funktionen:

GitHub Copilot (oder Alternativen) fungiert als KI-gestützter Programmierassistent, der Entwicklern dabei hilft, Code schneller zu schreiben und zu überprüfen.

Funktionen:

FirstMate FirstMate ist ein KI-Tool, das entwickelt wurde, um die Codequalität zu verbessern und Testprozesse zu optimieren.

Funktionen:

Harness ist eine KI-gesteuerte Plattform zur Automatisierung von CI/CD-Pipelines und zur Verwaltung von Bereitstellungen.

Funktionen:

Dynatrace Davis AI konzentriert sich auf die Überwachung und betriebliche Effizienz und nutzt prädiktive und generative KI-Funktionen.

Funktionen:

Obwohl es viele KI-Tools gibt, die DevOps-Workflows verbessern können, können wir durch die Erstellung eigener KI-Anwendungen mehr Kontrolle und Flexibilität gewinnen und Lösungen an unsere spezifischen Bedürfnisse anpassen. Sehen wir uns die grundlegenden Bausteine für die Erstellung von KI-Anwendungen an, beginnend mit generativer KI und Large Language Models (LLMs).

KI hat einen langen Weg zurückgelegt, und eine Unterkategorie der KI hat in den letzten Jahren wie keine andere an Zugkraft gewonnen:

Generative KI (GenAI) ist eine Unterart der KI, die sich auf die Erstellung neuer Inhalte wie Text, Bilder und Audio konzentriert. Sie wird von Large Language Models (LLMs) angetrieben, die auf riesigen Datensätzen trainiert werden, um menschenähnliche Sprache zu verstehen und zu generieren.

Bei der generativen KI geht es nicht nur um Automatisierung, sondern auch darum, Kreativität und Innovation in großem Maßstab zu ermöglichen und Aufgaben zu lösen, die normalerweise menschliches Verständnis und Denken erfordern würden.

LLMs sind das Rückgrat der Generativen KI. Diese Modelle, wie z. B. GPT-4, werden mit riesigen Mengen an Textdaten trainiert, um menschenähnliche Sprache zu verstehen und zu erzeugen. Das macht sie so besonders:

Wenn wir eine Abfrage (Eingabeaufforderung) an ein LLM senden, verarbeitet es die Eingabe Token für Token und generiert eine Antwort auf der Grundlage von Wahrscheinlichkeiten, die aus seinen Trainingsdaten abgeleitet werden. LLMs „denken“ zwar nicht wie Menschen, aber ihre Fähigkeit, die wahrscheinlichste Abfolge von Token vorherzusagen, macht sie für Aufgaben in natürlicher Sprache unglaublich leistungsfähig.

Wenn Sie nach Möglichkeiten suchen, LLMs zu betreiben und mit ihnen zu experimentieren, stehen Ihnen cloudbasierte Lösungen wie OpenAI Playground oder lokale Tools wie Ollama zur Verfügung. OpenAI Playground bietet Skalierbarkeit und Benutzerfreundlichkeit, während Ollama die lokale Ausführung von Modellen ermöglicht und mehr Datenschutz und Offline-Funktionen bietet. Wenn Sie daran interessiert sind, Ihre eigenen LLMs zu betreiben, lesen Sie unseren Blogbeitrag über Empowering Local AI.

Eine Einschränkung von LLMs ist ihre Abhängigkeit von vorab trainierten Daten, die möglicherweise nicht die neuesten oder bereichsspezifischen Informationen enthalten. Hier kommt die Retrieval-Augmented Generation (RAG) ins Spiel.

RAG kombiniert die Fähigkeiten von LLMs zur Inhaltsgenerierung mit der externen Wissensbeschaffung. Es funktioniert wie folgt:

Stellen Sie sich einen Chatbot für ein Produktsupport-Team vor. Wenn ein Benutzer eine Frage stellt, ruft der Chatbot Informationen aus der Produktdokumentation ab und kombiniert sie mit seinen Fähigkeiten zur Sprachgenerierung, um eine präzise und hilfreiche Antwort zu liefern.

KI revolutioniert DevOps, indem sie die dringendsten Herausforderungen angeht und es Teams ermöglicht, intelligenter und nicht härter zu arbeiten. Generative KI und LLMs stehen an der Spitze dieses Wandels und bieten neue Möglichkeiten zur Erstellung, Zusammenarbeit und Innovation von Arbeitsabläufen. Mit Techniken wie der Retrieval-Augmented Generation können wir die Grenzen des Möglichen erweitern, indem wir das Beste aus den generativen und Retrieval-Fähigkeiten der KI kombinieren.

Im nächsten Teil dieser Serie werden wir uns eingehender mit der Erstellung eigener KI-Anwendungen mit Frameworks wie LangChain befassen und untersuchen, wie Qualität und Sicherheit in LLM-gestützten Systemen gewährleistet werden können, also bleiben Sie dran!

Wenn Sie noch mehr erfahren möchten, sehen Sie sich unbedingt unsere Videos unseres neuesten KI-Workshops für DevOps-Engineers auf YouTube an:

Sie interessieren sich für unsere Trainings oder haben einfach eine Frage, die beantwortet werden muss? Sie können uns jederzeit kontaktieren! Wir werden unser Bestes tun, um alle Ihre Fragen zu beantworten.

Hier kontaktieren